Eksempler på digitale data: lyd og bilde

Som vi har sett, kan data kan være digitale eller analoge – men det er bare digitale data som kan behandles av en datamaskin.

La oss se på to konkrete eksempler, nemlig digitale representasjoner av lyd og bilde. Hvordan ser egentlig dette ut i en datamaskin?

Lyd: fra analog til digital

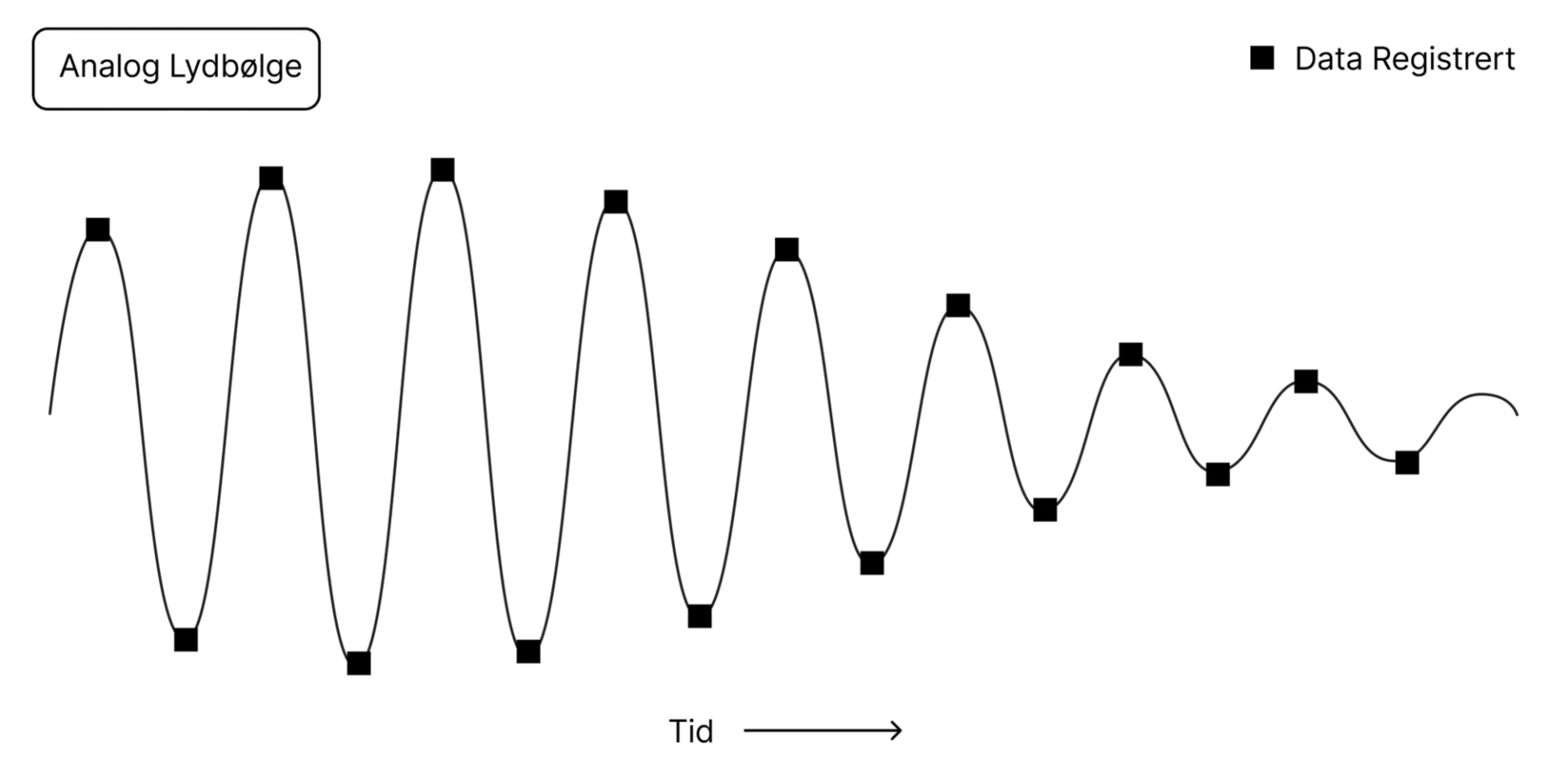

Her ser du et eksempel på hvordan analoge data fra lyd – altså lydbølger – kan representeres digitalt i en datamaskin.

Lydbølger er analoge. Vi lærte definisjonen av analog tidligere – signalet er her basert på fysiske, kontinuerlig varierbare størrelser. For å oversette dette til et digitalt format må vi ta såkalte samples eller samplinger (bokstavelig oversatt: prøve eller stikkprøve) med jevne tidsintervaller. Figuren ovenfor viser punkter hvor det er tatt samples.

For en lyd-CD er det vanlig med en sample rate (frekvens) på 44.100 samplinger per sekund (44,1 kilohertz, kHz). I tillegg er det relevant hvor mye informasjon som fanges opp hver gang man leser av lydbølgen – altså hvor mange bits med data som lagres for hver enkelt av disse 44.100 stikkprøvene. En såkalt bitdybde på 8 eller 16 biter er vanlig, mens hifi-entusiaster gjerne vil ha 24. Og man trenger to kanaler for stereolyd (en for hvert øre), noe som dobler informasjonsinnholdet. (Hifi-lyd kan ta opp flere gigabyte med harddiskplass per album).

Du kan tenke på det som at vi måler lydbølgene i «to dimensjoner» – lengde/tid og dybde. Altså både hvor ofte den samples, og hvor mye informasjon som lagres i hver sample.

Strømmetjenester som Spotify bruker algoritmer som komprimerer lyden, noe som betyr at det typisk er mindre informasjonsinnhold når man spiller musikken fra Spotify enn når den kommer fra en CD. Mens en CD vil spille av 1.411 kilobits per sekund (Kbps), vil MP3-filer og musikken du strømmer typisk ha en såkalt bitrate på 96 til 320 Kbps. Du skal riktignok ha et trent øre og godt utstyr for å virkelig sette pris på forskjellen i lydkvalitet.

Bilde: fra lys til piksler

Som vi har sett i eksempelet med lydbølger, må analoge signaler representeres digitalt i form av bits. Slik er det også med bilder. Dette er i utgangspunktet også analoge signaler – i form av elektromagnetiske bølger som øynene våre (og kamerasensorer) oppfatter som lys og farger.

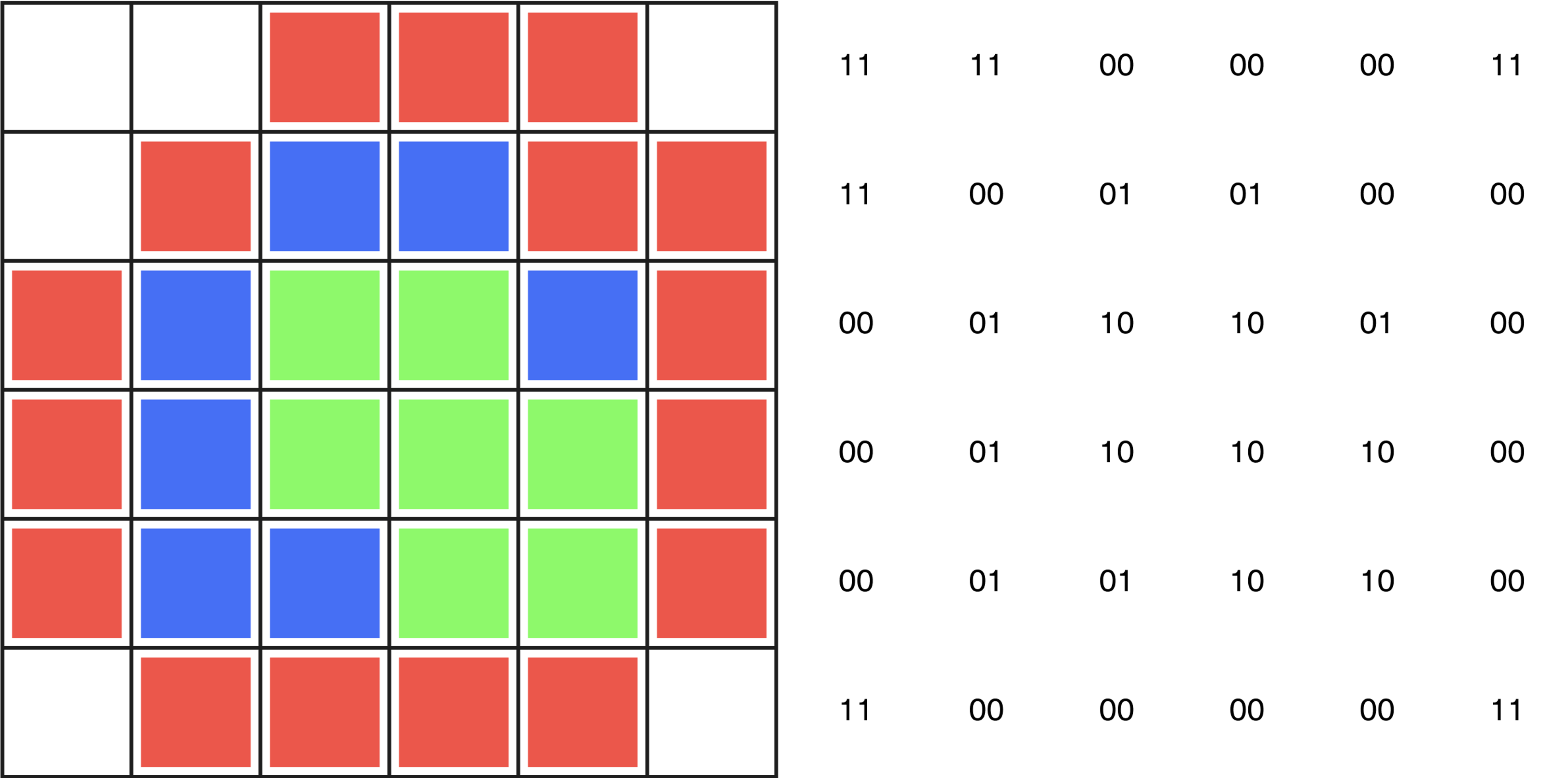

Når vi skal digitisere dette, kan vi også her snakke om to dimensjoner som avgjør kvaliteten i de digitale bildene: nemlig oppløsning (ikke ulikt lydfilers «sample rate») og bitdybde.

Med oppløsning menes antall piksler / bildepunkter. Et fotografi på 24 megapiksler består for eksempel av 24 millioner piksler, mens et bilde med 8 megapiksler består av 8 millioner piksler. Mens en 4K-video (3840x2160 piksler) har fire ganger så mange piksler som en HD-video (1920x1080 piksler).

Bitdybden er på sin side hvor mange bits med data som representerer hver enkelt piksel. Jo flere bits, dess flere mulige farger kan vi gjengi.

I figuren ovenfor ser du et forenklet eksempel på hvordan piksler kan representeres binært, altså digitalt. Her brukes 2-bit representasjon av hver farge, noe som gir 2^2, det vil si 4 mulige farger.

Et vanlig digitalt bilde i jpg-format bruker 8 bits for å representere hver av hovedfargene rød, grønn og blå (RGB). Til sammen gir dette 24 bits per piksel. Det vil si 256 mulige nyanser av hver farge, og til sammen 16,8 millioner farger når du kombinerer dem.

Når du tar bilder i råformat på et systemkamera, kan du jobbe med en bitdybde på 12, 14 eller 16 bits per kanal. Akkurat som at hifi-entusiasten vil ha større bitdybde og mer informasjon i filene, gir dette fotografer flere farger og nyanser å jobbe med.

Data på ulike nivåer

For å understreke det vi har sett er data på sitt laveste nivå en eller flere biter i kombinasjon. Men vi kan også snakke om data på et høyere nivå, for eksempler piksler i et bilde eller tegn i et tegnsett. Eller et enda høyere nivå, hvor et bilde (satt sammen av piksler) er data og en tekst (satt sammen av tegn/bokstaver) er data.